Risikodaten-Management

EZB-Anforderungen erfolgreich navigieren

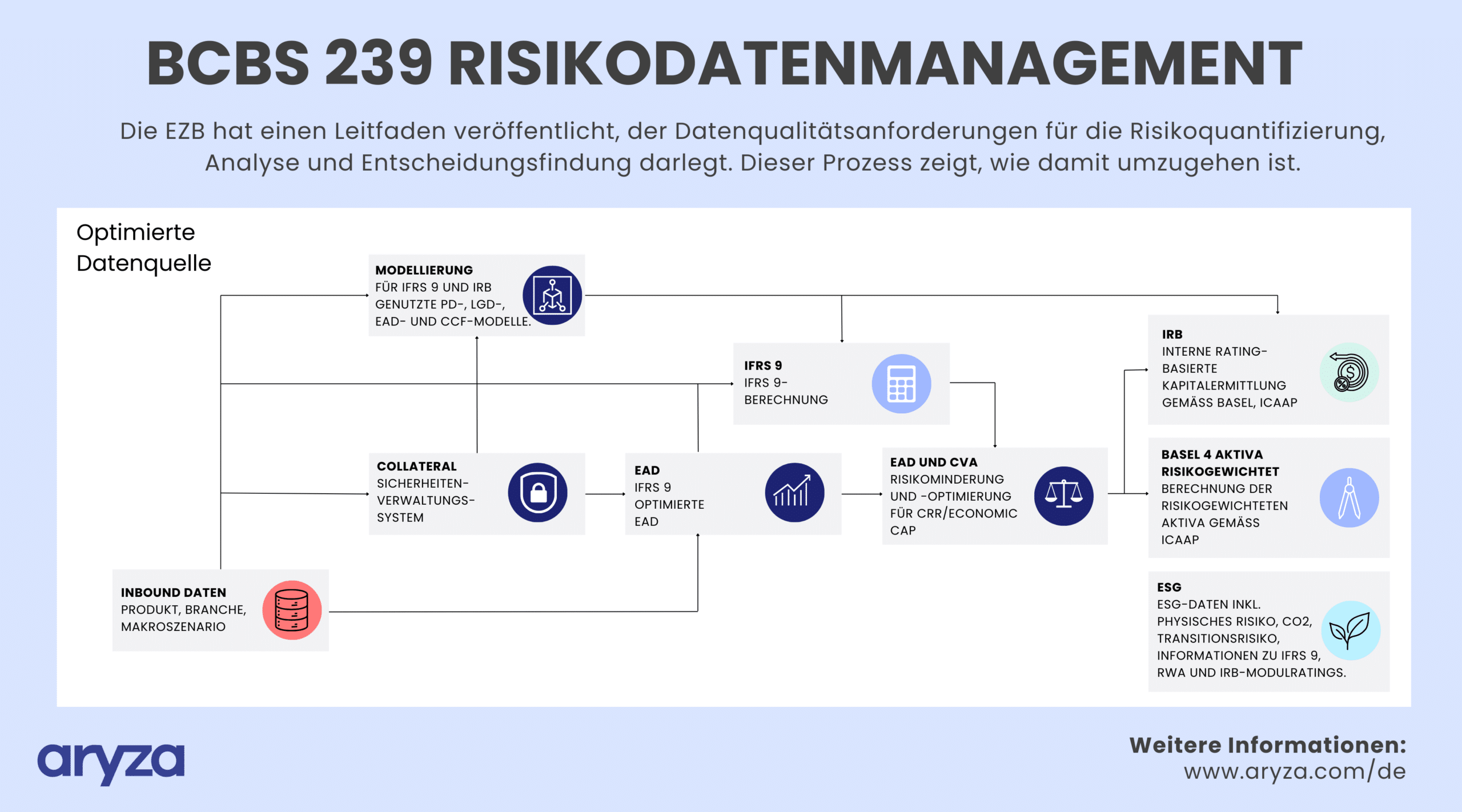

Die EZB erhöht den Druck auf die Bankenlandschaft. Im Rahmen eines neu veröffentlichten Leitfadens fordern die Währungshüter eine Verbesserung des Risikodatenmanagements. Eine gute Datenqualität sei für die Quantifizierung von Risiken, für Analysen und richtige Entscheidungen unerlässlich. Die Folgen für die Nichteinhaltung sind gravierend.

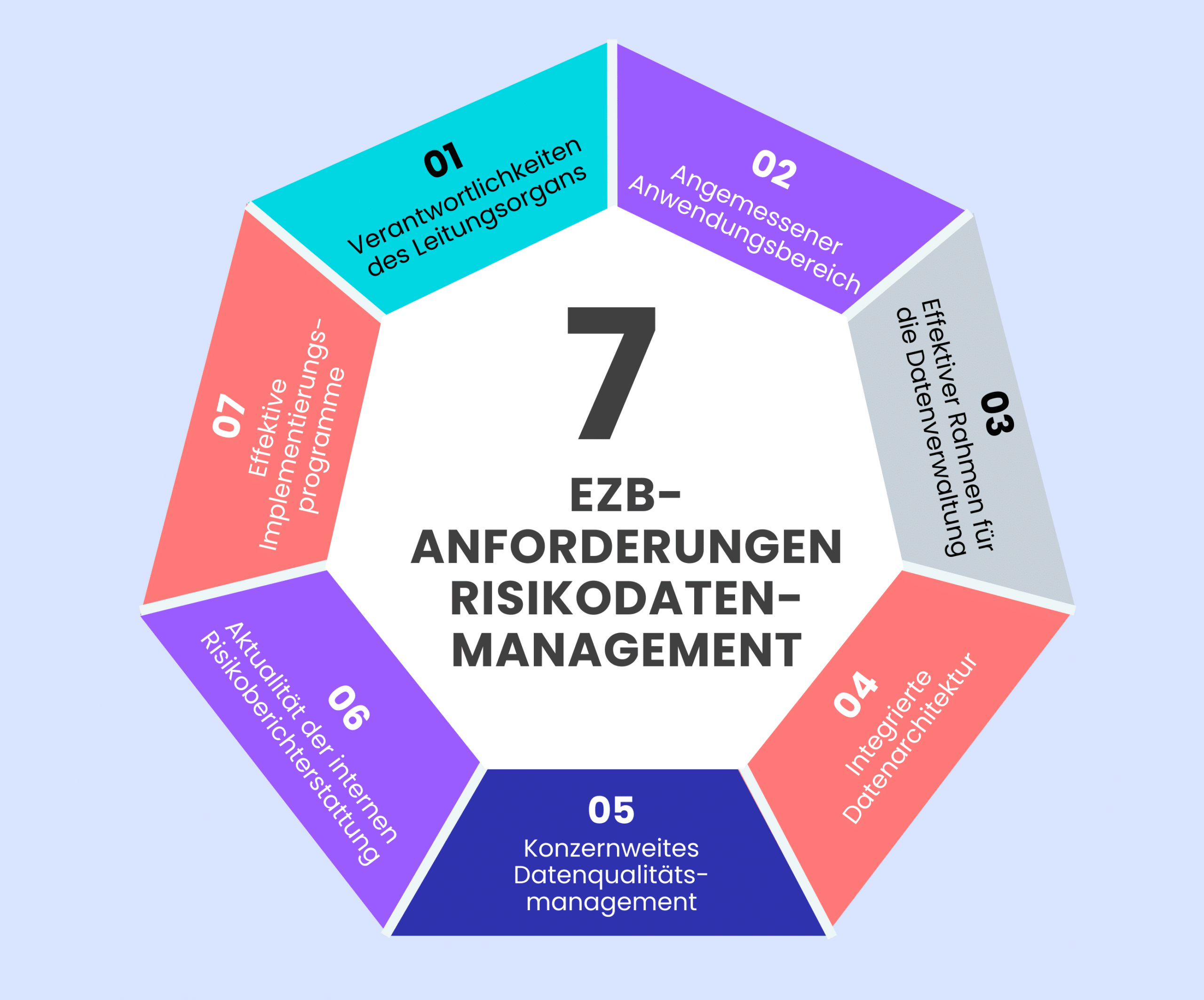

EZB-Anforderungen

7 Vorgaben für das Riskodatenmanagement

In ihrem ,guide on effective risk data aggregation and risk reporting’ (Leitfaden zur effektiven Aggregation und Berichterstattung von Risikodaten) scheut die Bankenaufsicht keine Kritik: Die Institute konzentrierten sich noch immer auf Kosten und Implementierungsherausforderungen anstatt auf die Vorteile der Behebung langjähriger Mängel in diesem Bereich.

Laut EZB sind viele Institute noch weit vom geforderten Zielzustand entfernt.

Die Behörde hat daher eine Aufsichtsstrategie für 2023-2025 entwickelt. Institute sollen prüfen, ob ihre Datenmanagement-Rahmenwerke dem geltenden Recht entsprechen.

Implementierung Schritt 1

Datenmanagement and Compliance

Die richtigen Metadaten sind entscheidend für ein einheitliches Risikodatenmanagement. Sie geben den Verwaltern der Daten Auskunft darüber, woher die Daten stammen, was mit ihnen passiert und wie sie genutzt werden. Die Aufsichtsorgane der Institution können dann sicherstellen, dass die Richtlinien zur Datenqualität sowie zur Klassifizierung, Speicherung, Sicherung und Nutzung eingehalten werden.

Implementierung Schritt 2

Lösungen zur Daten-Automatisierung

Zur Durchsetzung der Datenmanagement-Richtlinien und langfristigen Compliance empfiehlt die EZB technische Lösungen. Automatisierung reduziert manuelle Tätigkeiten und betriebliche Risiken erheblich.

Der Markt bietet zahlreiche Funktionen, darunter „Must-Haves“ und“Nice-to-Haves“, je nach Unternehmensbedarf.

Must-Haves

Folgende automatisierte Funktionen sind für effektives Datenmanagement unerlässlich, insbesondere für Organisationen, die mit großen Datenmengen arbeiten, Compliance-Verpflichtungen haben oder eine hohe Datenintegrität benötigen:

- Extraktion von Metadaten: Entscheidend für Verständnis und korrekte Nutzung von Daten, insbesondere für den Bereich Governance und Compliance.

- Aufbau der Datenherkunft: Wichtig für die Nachverfolgung von Datenherkunft, -transformation und -nutzung; wichtig für Audits, Compliance und das Verständnis von Datenabhängigkeiten.

- Klassifizierung der Daten: Wichtig für die Einhaltung von Datenschutzbestimmungen (wie DSGVO) und für die Sicherung sensibler Informationen.

- Prüfpfade und Historie: Notwendig für Compliance und das Verständnis von Daten-Änderungen und -Modifikationen im Laufe der Zeit.

- Messung und Überwachung der Datenqualität: Entscheidend für die Sicherstellung von Datengenauigkeit und -zuverlässigkeit, die sich auf Entscheidungsprozesse und Betriebseffizienz auswirken.

- Berichterstattung über Datenmanagement-KPIs: Essentiell für die Überwachung der Effektivität von Datenmanagementpraktiken und für die strategische Entscheidungsfindung.

Nice-to-Haves

Diese Funktionen verbessern Funktionalität und Benutzererfahrung, sind aber oft nicht kriegsentscheidend für grundlegende Datenmanagementanforderungen:

- Notifications: Nützlich, um relevante Stakeholder zu informieren, aber nicht kritisch, außer bei spezifischen Workflow- oder Compliance-Anforderungen.

- Erkennung von Anomalien durch Datenprofilierung: Verbessert die Datenintegrität, indem Ausreißer oder Fehler identifiziert werden, ist jedoch nicht essentiell, es sei denn, die Organisation hat hohe Anforderungen an die Datengenauigkeit.

- Datenbereinigungsprozesse: Hilfreich zur Aufrechterhaltung der Datenqualität, aber möglicherweise nicht notwendig für Organisationen mit weniger strengen Datenqualitätsanforderungen.

- Self-Service-Fähigkeiten: Vorteilhaft, um die Abhängigkeit von Datenteams zu verringern, aber keine Kernanforderung für Datenmanagementfunktionen.

Implementierung – Schritt 3

Der Aryza-Ansatz

- Erstellung eines Geschäftsdatenkatalogs: Der Prozess beginnt mit der Erstellung eines Business Requirements Specification-Dokuments (BRS). Dieses Dokument bewertet gründlich jedes Datenelement, das für die Integration in das Rahmenwerk zur Risikodatenaggregation erforderlich ist.

- Entwicklung des technischen Katalogs: Aus dem anfänglichen BRS-Dokument wird ein System Requirements Specification-Dokument (SRS) abgeleitet. Es spezifiziert, welche IT-Systeme die erforderlichen Daten hosten, skizziert die Datenstruktur und enthält Zuordnungen, die die Datenelemente vom BRS mit denen im SRS verknüpfen.

- Entwurf des logischen Datenmodells: In einem weiteren Schritt wird das Logische Datenmodell (LDM) für das Risikodatenzentrum entworfen, um alle gesammelten Daten effektiv aufzunehmen.

- Erstellung des physischen Datenmodells: Ein Physisches Datenmodell (PDM) wird erstellt, um eine optimale physische Speicherung und den Abruf von Daten innerhalb des Risikodatenzentrums sicherzustellen.

- Entwurf der System-Schnittstellen: Schnittstellen zwischen den verschiedenen am Datenübertragungsprozess beteiligten Systemen werden entworfen und spezifiziert. Dieser Schritt umfasst die Erstellung von SRS-Dokumenten für jedes Quellsystem und die Verbindungen zwischen den Quellen und dem Datenzentrum.

- Dokumentation der Datenübertragungsprozesse: Detaillierte Dokumentationen skizzieren jeden Schritt der Datenübertragungsprozesse von ihren Quellen zum Risikodatenzentrum. Dies umfasst Bewertungen potenzieller Datenkorruptionsrisiken an jedem Übertragungspunkt, sei es bei einfacher Datenbewegung oder -transformation.

- Analyse von Datenabhängigkeiten und Engpässen: Eine Analyse wird durchgeführt, um Abhängigkeiten und Engpässe in den Datenübertragungs- oder Verarbeitungsstufen zu identifizieren. Diese Analyse hilft bei der Optimierung des Übertragungsprozesses, um sicherzustellen, dass Risikodaten potenziellen Stakeholdern rechtzeitig zur Verfügung stehen, in der Regel am nächsten Geschäftstag.

Effektives Risikodatenmanagement ist entscheidend für fundierte Entscheidungen und die Einhaltung von EZB-Vorschriften. Durch den Einsatz fortschrittlicher Technologie und einer strukturierten Implementierung gewährleistet Aryza Datenintegrität, Compliance und Zugänglichkeit in der gesamten Organisation.

Sanjin Bogdan, Head of IFRS 9 Aryza